Comprendre le Waterfall en Finance : Répartition des Gains et Stratégies d’Optimisation. Un article GOWeeZ pour vous expliquer Le waterfall, ou cascade de distribution. Ce mécanisme est clé en finance,

De manière humble, on vient vous présenter au gros crayon, une esquisse de cette évolution de l’Intelligences Artificielle.

En 1956, la conférence de Dartmouth College porte le nom plus complet suivant : « Dartmouth Summer Research Project on Artificial Intelligence »

Cette conférence est organisée par des pionniers de l’IA, Notamment John McCarthy, Docteur en mathématique.

Il créé notamment la technique du temps partagé, qui permet à plusieurs utilisateurs d’employer simultanément un même ordinateur.

Marvin Minsky est un scientifique américain; fondateur du groupe d’intelligence artificielle du M.I.T.

Cette conférence marqué le début officiel de la recherche moderne en intelligence artificielle.

En effet, son objectif était d’explorer la possibilité de créer des machines capables de simuler l’intelligence humaine.

Bien que les premiers résultats aient été modestes, cette conférence a catalysé l’intérêt et a jeté les bases d’un domaine de recherche désormais en constante évolution.

Depuis lors, l’IA connait des progrès considérables, notamment dans des domaines tels que le machine learning et le deep learning. Cette Conférence de Dartmouth reste un événement, en posant la première prière dans l’histoire de l’IA.

On parle d’ailleurs pour l’époque d’I.A statistiques.

On parle beaucoup d’I.A. D’ailleurs si vous demandez à Chat GPT de vous lister la liste des I.A, il propose 8 types d’I.A, allant de celle faible jusqu’à celle embarquée.

Mais une personnalité comme Luc Julia, que nous avons pu écouter en Février 2024, lors d’une conférence à la BPI, apporte 3 mouvements.

On le disait, ça a commencé par l’I.A statistiques. Celle-ci sert à modéliser, analyser et tirer des conclusions à partir des Data. Elle a évolué et s’est dupliqué durant les Années 60, 70, 80,

Elle joue toujours un rôle essentiel dans de nombreux domaines, notamment l’analyse de données comme l’analyse en composantes principales (ACP) ou le Clustering utilisé notamment dans les processus d’ETL (Extract – Transform – Load).

Ce type d’ I.A était basée sur des systèmes experts. Elle faisait appel à la logique.

Dans les années 90, l’I.A est revenu à la mode avec l’avènement du Big Data.

A partir de là, 3 grandes vagues se sont présentés aux experts.

Utilisé avec beaucoup de data (entre 100 000 et 1 000 000 d’objets de Data).

Le machine learning est une technique permettant aux ordinateurs d’apprendre à effectuer des tâches sans être explicitement programmés pour les faire.

Ainsi, au lieu de suivre des instructions spécifiques provenant de l’Homme, les ordinateurs utilisent des algorithmes pour analyser les données et apprendre des modèles de celles-ci.

Ceci lui offre la capacité à prendre des décisions ou de faire des prédictions sur de nouvelles données.

L’ordinateur apprend de l’expérience passée pour améliorer ses performances futures.

Utilisé avec beaucoup de data. Nous passons sur une échelle de plusieurs millions d’objets de Data.

Cela permet notamment de travailler sur la reconnaissance.

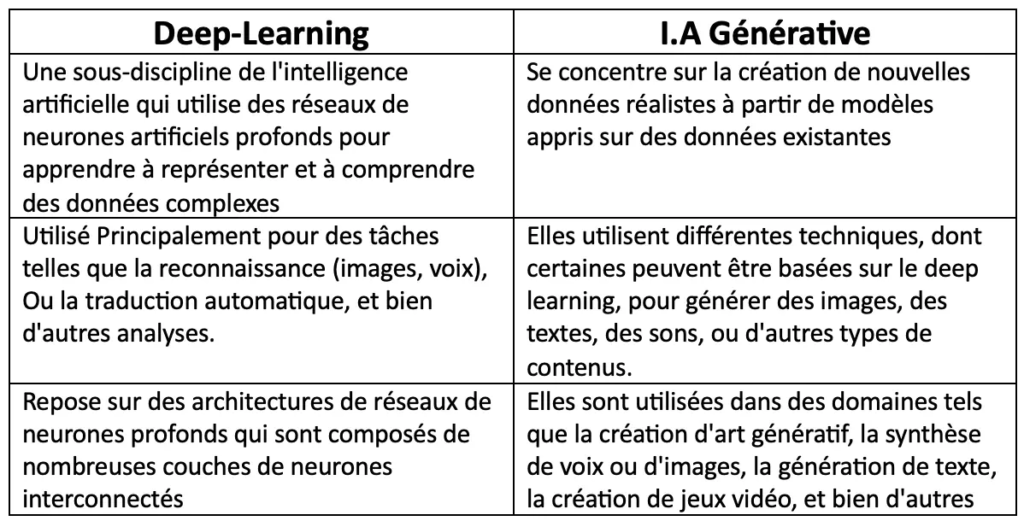

En effet, Le deep learning est une branche de l’intelligence artificielle (IA) qui utilise des réseaux de neurones artificiels pour apprendre à représenter et à comprendre des données complexes.

Ces réseaux de neurones, inspirés par le fonctionnement du cerveau humain, sont composés de nombreuses couches de neurones interconnectés, d’où le terme « profond ».

Le deep learning est principalement utilisé pour des tâches telles que la reconnaissance d’images et de voix, la traduction automatique, et d’autres applications de traitement des données.

Nous passons d’une échelle de plusieurs millions d’objets de Data à plusieurs Milliards de d’objets.

Nous parlions juste avant du deep learning qui est une méthode d’apprentissage automatique utilisée pour comprendre et représenter des données complexes.

L’intelligence artificielle générative est une branche de l’IA axée sur la création de nouvelles données réalistes à partir de modèles appris à partir de données existantes.

Bien que le deep learning puisse être utilisé dans le cadre de l’IA générative, ils représentent deux concepts distincts avec des applications différentes.

Les I.A génératives apparaissent au « grand public » . Au-delà de la révolution technologique qui se présente, c’est une révolution d’usage qui s’opère fin 2022.

En effet, le fameux « Prompt » permet de désacraliser la relation entre l’homme et l’I.A. Chat GPT devient un nouvel entrant dans la quête d’informations.

Ces prompts permettent d’enlever les interfaces et donc de pouvoir discuter directement avec ces I.A, et d’ouvrir le champs des interactions possibles.

Les ordinateurs quantiques ont le potentiel d’accélérer certains aspects de l’analyse de données et de l’IA. Néanmoins, leur impact sur la capacité à gérer de grandes quantités de données dépendra de nombreux facteurs.

En effet, cela passe par le développement d’algorithmes quantiques appropriés et leur intégration dans les systèmes d’IA existants.

A lire également :

Nous avions fait un article sur la société KONATUS, que GOWeeZ accompagne dans son développement. KONATUS propose une IA embarquée sur les PPM. (Lire l’article)

Pour nous suivre :

Linkedin START-UP GOLF CHALLENGE

Fondateur de GOWeeZ et de MY PITCH IS GOOD

l'évolution technologique émerge comme le catalyseur principal de la compétitivité. Au sein de ce panorama en constante mutation, l'Intelligence Artificielle (IA) se profile comme une force motrice incontournable. Elle redéfinit les limites de l'efficacité opérationnelle et de l'innovation. À l'heure où les entreprises aspirent à rester le moteur économique d’un pays mais surtout la réalisation de l’individu, la symbiose entre l'IA et la compétitivité devient impérative.

Fabrice Clément Tweet

Goweez © 2025